堵住AI安全漏洞,法規之外更需技術制衡 需要共同發力使其良性發展

如今,AI換臉在網上被玩的不亦樂乎。喜歡哪個明星,就把所有電視劇主角都換成他的臉,如果只是單純娛樂,貌似也無可厚非。但可怕的是,你的臉很可能會被“植入”到色情視頻然后被打包販賣,甚至你的手機、電腦、智能門鎖等應用了人臉識別技術的設備也可能被AI換臉輕松攻破。有人用AI視頻造假,亦或是犯罪,似乎就沒那么好玩了。

刷臉支付、人臉識別……不可否認,人工智能技術給人們的生活帶來了諸多便利。“但我們也應當正視,當前人工智能技術還處在初步發展階段,仍然面臨著一些挑戰。”清華大學教授、清華大學人工智能研究院基礎理論研究中心主任朱軍說。

“任何技術都是一把雙刃劍,當AI技術應用到越來越多的場景,由于AI算法本身存在漏洞所引發的安全問題必須引起足夠重視。同時,AI技術的濫用也將引發安全隱患,比如隱私與倫理問題。當AI開始觸碰邊界問題,安全性就成為AI發展過程中必須思考的課題。”北京瑞萊智慧科技有限公司(以下簡稱RealAI)高級產品經理張旭東在接受科技日報記者采訪時說。

技術漏洞帶來AI安全問題

回家,到單元樓門口,刷一下臉,門就開了。人臉解鎖已經成為生活中最常見的AI應用場景之一。然而,很少有人會想到,當前的AI算法存在明顯的“安全盲點”。

RealAI團隊就曾做過相關研究:針對識別算法漏洞,可生成一類名為對抗樣本的“噪音”,惡意誤導AI算法輸出非預期的結果,誘導識別系統出錯。團隊成員通過一張打印上對抗樣本“噪音”的紙,成功地讓研究對象在識別系統下實現“隱身”,如果再把紙貼在其他實物上,比如小車模型上,也可以讓該物體在識別系統下完全“消失不見”。此外,他們還研發了一種帶有噪點的“眼鏡”,只要戴上,即使不是本人,也能成功破解商用智能手機的刷臉解鎖,甚至包括門鎖等其他人臉識別設備。

“AI算法漏洞本質上是安全問題的一大類,而解決安全問題往往是攻防兩端不斷對抗、演化的過程。”張旭東說。目前對主流的攻擊手段都有比較有力的防御手段,如可以通過訓練模型去除對抗“噪音”,或是檢測出對抗樣本以后將其從數據中去除,以及使用攻擊算法生成大量對抗樣本對模型做對抗訓練等方式來解決這些問題。

由于AI換臉技術也在不段進化,早期換臉技術生成的視頻中人物往往不會眨眼,可根據一些較為明顯的特征直接肉眼判斷。但隨著深度偽造技術的不斷演化,這些鑒別方法已不再有效。

“面對這種情況,我們會根據當前市面上流行的換臉算法生成海量的訓練樣本,再結合貝葉斯學習處理還未出現的新型虛假視頻。簡單理解,就是基于主流的甚至更為領先的生成技術制作出大量逼真的假視頻,再利用這些假視頻訓練出一個新的模型。做的假視頻越逼真,訓練出來的模型分辨能力就越強。”張旭東說。

要守好技術和法規兩道關

“AI技術濫用最顯性的問題在于個人信息被輕易‘操縱’,這背后可能會引發隱私泄露、身份危機,而且還會催生出更加隱秘、難以偵察的新型黑產,如色情黑產、金融欺詐等。”張旭東說。

此外,AI技術濫用的潛在效應還將蔓延到大眾的信息獲取和社會信任層面,引導公眾輿論、引發社會信任危機,比如美國就曾流出國家領導人被惡搞的視頻,制作者利用視頻煽動政治暴力、破壞選舉、擾亂外交。長此以往,難以辨別真相的公眾無法選擇相信還是不相信,如果選擇相信可能會繼續給不法分子帶來可趁之機,如果選擇不相信則可能帶來長期的社會冷漠。

張旭東表示,AI安全問題牽一發而動全身,守好技術和法規兩道“關卡”是當務之急,同時需要聯動社會各界力量,從監管機構、AI科技企業到普通公眾共同重視、共同發力才能真正的從根本上使其良性發展。

欣喜的是,AI安全問題已經引起國內相關監管機構的重視。此前,網信辦就正式發布《網絡音視頻信息服務管理規定》,指出自2020年1月1日起,AI造假音視頻不得隨意發布。新規定中關于AI造假音視頻的規定主要有四條:按照國家有關規定開展安全評估、以顯著方式予以標識非真實音視頻信息、不得利用AI造假技術發布虛假新聞、部署AI造假音視頻鑒別技術和健全辟謠機制等。

“當然,最有效、最可行的解決方法仍是依靠技術制衡技術。”張旭東說,這主要包括兩方面,一是開發出高精度的AI檢測算法與檢測產品,從源頭制止虛假內容的泛濫傳播;二是開發出相應的“防火墻”技術,從防御端鑄造高墻,保障配備了人臉識別系統的公共安全設備攻不可破。

-

工信部:持續改善網絡基礎設施建設 引領帶動綠色智能家電消費 在自家冰箱上下單,就能收到北京寄來的地道烤鴨;只要進入千兆城市,就能享受遍布的極速WiFi……在國務院新聞辦公室日前舉行的例行吹風會...

工信部:持續改善網絡基礎設施建設 引領帶動綠色智能家電消費 在自家冰箱上下單,就能收到北京寄來的地道烤鴨;只要進入千兆城市,就能享受遍布的極速WiFi……在國務院新聞辦公室日前舉行的例行吹風會... -

打造低碳零碳負碳原創技術的策源地 中國環保發起雙碳科創園 5日,由中國環境保護集團(以下簡稱中國環保)發起的中國環保雙碳科創園暨中歐雙碳產業園(以下簡稱園區)啟動會暨雙碳戰略座談會在北京市順義

打造低碳零碳負碳原創技術的策源地 中國環保發起雙碳科創園 5日,由中國環境保護集團(以下簡稱中國環保)發起的中國環保雙碳科創園暨中歐雙碳產業園(以下簡稱園區)啟動會暨雙碳戰略座談會在北京市順義 -

支持資金近1.5億元!內蒙古啟動“雙碳”科技創新重大示范工程 記者6月7日從內蒙古科技廳獲悉,為將全區雙碳科技創新工作迅速落到實處,內蒙古按照圍繞產業鏈部署創新鏈、圍繞創新鏈布局產業鏈的原則,緊

支持資金近1.5億元!內蒙古啟動“雙碳”科技創新重大示范工程 記者6月7日從內蒙古科技廳獲悉,為將全區雙碳科技創新工作迅速落到實處,內蒙古按照圍繞產業鏈部署創新鏈、圍繞創新鏈布局產業鏈的原則,緊 -

我國首個!首批兩臺HXN6型內電混合動力機車成功下線 6月9日,我國首批兩臺商品化HXN6型內電混合動力機車在中車資陽機車有限公司(以下簡稱中車資陽公司)成功下線。該車動力源采用動力電池組+柴

我國首個!首批兩臺HXN6型內電混合動力機車成功下線 6月9日,我國首批兩臺商品化HXN6型內電混合動力機車在中車資陽機車有限公司(以下簡稱中車資陽公司)成功下線。該車動力源采用動力電池組+柴 -

好消息!2022年起企業可提前享受前三季度研發費用加計扣除政策 近日,國家稅務總局印發《關于企業預繳申報享受研發費用加計扣除優惠政策有關事項的公告》,明確從2022年起,企業可以在每年10月申報期申報

好消息!2022年起企業可提前享受前三季度研發費用加計扣除政策 近日,國家稅務總局印發《關于企業預繳申報享受研發費用加計扣除優惠政策有關事項的公告》,明確從2022年起,企業可以在每年10月申報期申報 -

智能中遇見“未來”!中新新天津生態城將推出6個智慧應用場景 第六屆世界智能大會云端召開在即。作為世界智能大會的永久展示基地,中新天津生態城今年將推出哪些值得期待的智慧應用場景?在智能中遇見未

智能中遇見“未來”!中新新天津生態城將推出6個智慧應用場景 第六屆世界智能大會云端召開在即。作為世界智能大會的永久展示基地,中新天津生態城今年將推出哪些值得期待的智慧應用場景?在智能中遇見未

-

【實探】中藥價格狂飆過后的“藥都”亳州:貨車司機閑坐等接單 【實探】中藥價格狂飆過后的“藥都”亳州:貨車司機閑坐等接單,當歸,黨

【實探】中藥價格狂飆過后的“藥都”亳州:貨車司機閑坐等接單 【實探】中藥價格狂飆過后的“藥都”亳州:貨車司機閑坐等接單,當歸,黨 -

東方日升(300118.SZ)擬10股派2元 于7月14日除權除息 智通財經APP訊,東方日升(300118)(300118 SZ)公告,公司2022年年度權益

東方日升(300118.SZ)擬10股派2元 于7月14日除權除息 智通財經APP訊,東方日升(300118)(300118 SZ)公告,公司2022年年度權益 -

中國蜀塔(08623)擬420萬元收購雅安寶盛金屬材料余下30%股權 智通財經APP訊,中國蜀塔(08623)公布,于2023年7月7日,該公司全資附屬

中國蜀塔(08623)擬420萬元收購雅安寶盛金屬材料余下30%股權 智通財經APP訊,中國蜀塔(08623)公布,于2023年7月7日,該公司全資附屬 -

南王科技最新公告:擬投建高端環保食品級紙制品項目 南王科技公告,公司擬在廣東省鶴山市鶴山工業城A區設立全資子公司“廣

南王科技最新公告:擬投建高端環保食品級紙制品項目 南王科技公告,公司擬在廣東省鶴山市鶴山工業城A區設立全資子公司“廣 -

南王科技(301355.SZ):擬設立子公司投資建設高端環保食品級紙制品項目 格隆匯7月7日丨南王科技(301355 SZ)公布,公司于2023年7月7日召開第三

南王科技(301355.SZ):擬設立子公司投資建設高端環保食品級紙制品項目 格隆匯7月7日丨南王科技(301355 SZ)公布,公司于2023年7月7日召開第三 -

拉夏貝爾(06116):管理人仍有序開展債權申報、債務及資產核查等工作 智通財經APP訊,拉夏貝爾(603157)(06116)發布公告,自公司進入破產清算

拉夏貝爾(06116):管理人仍有序開展債權申報、債務及資產核查等工作 智通財經APP訊,拉夏貝爾(603157)(06116)發布公告,自公司進入破產清算 -

2023年7月7日江蘇省聚丙烯酰胺價格最新行情預測 中國報告大廳2023年7月7日江蘇省聚丙烯酰胺價格最新走勢監測顯示:蘇州

2023年7月7日江蘇省聚丙烯酰胺價格最新行情預測 中國報告大廳2023年7月7日江蘇省聚丙烯酰胺價格最新走勢監測顯示:蘇州 -

CCER重啟真的要來了!生態環境部發布公開征求意見通知 CCER重啟真的要來了!生態環境部發布公開征求意見通知,配額,交易,ccer,

CCER重啟真的要來了!生態環境部發布公開征求意見通知 CCER重啟真的要來了!生態環境部發布公開征求意見通知,配額,交易,ccer, -

云南建投混凝土(01847)附屬高分子公司訂立保理協議 智通財經APP訊,云南建投混凝土(01847)發布公告,于2023年7月7日,該公

云南建投混凝土(01847)附屬高分子公司訂立保理協議 智通財經APP訊,云南建投混凝土(01847)發布公告,于2023年7月7日,該公 -

明源云(00909.HK)委任梁瑞冰為聯席公司秘書 格隆匯7月7日丨明源云(00909 HK)宣布,司徒嘉怡因其他工作安排,已提呈

明源云(00909.HK)委任梁瑞冰為聯席公司秘書 格隆匯7月7日丨明源云(00909 HK)宣布,司徒嘉怡因其他工作安排,已提呈 -

彩客新能源(01986)4月21日斥資8.58萬港元回購6.2萬股 智通財經APP訊,彩客新能源(01986)發布公告,于2023年4月21日,該公司

彩客新能源(01986)4月21日斥資8.58萬港元回購6.2萬股 智通財經APP訊,彩客新能源(01986)發布公告,于2023年4月21日,該公司 -

富祥藥業:7月6日接受機構調研,包括知名機構盤京投資的多家機構參與 2023年7月7日富祥藥業(300497)發布公告稱公司于2023年7月6日接受機構

富祥藥業:7月6日接受機構調研,包括知名機構盤京投資的多家機構參與 2023年7月7日富祥藥業(300497)發布公告稱公司于2023年7月6日接受機構 -

廣東宏大:預計2023年1-6月盈利,凈利潤同比增20%至30% 廣東宏大發布業績預告,預計2023年1-6月歸屬凈利潤盈利3 02億元至3 27

廣東宏大:預計2023年1-6月盈利,凈利潤同比增20%至30% 廣東宏大發布業績預告,預計2023年1-6月歸屬凈利潤盈利3 02億元至3 27 -

馮奎章_馮奎 1、馮奎賣妻是明朝末年的故事。2、《馮奎賣妻》保定府有一對夫妻叫馮奎

馮奎章_馮奎 1、馮奎賣妻是明朝末年的故事。2、《馮奎賣妻》保定府有一對夫妻叫馮奎 -

注意!家里這些物品也要“防暑降溫” 入夏以來,多輪高溫天氣來襲用電需求量較常年同期偏高面對“烤”驗日常

注意!家里這些物品也要“防暑降溫” 入夏以來,多輪高溫天氣來襲用電需求量較常年同期偏高面對“烤”驗日常 -

2023年愛心售報|小報童帶病堅持來賣報 孩子成長迅速讓家長很欣慰 揚子晚報7月7日訊(記者季宇軒實習生王元釗)7月6日是2023年揚子晚報暑

2023年愛心售報|小報童帶病堅持來賣報 孩子成長迅速讓家長很欣慰 揚子晚報7月7日訊(記者季宇軒實習生王元釗)7月6日是2023年揚子晚報暑 -

粵電力A最新公告:預計上半年凈利潤8億元-9.5億元 同比扭虧為盈 粵電力A公告預計上半年凈利潤8億元95億元去年同期虧損1372億元同比扭虧

粵電力A最新公告:預計上半年凈利潤8億元-9.5億元 同比扭虧為盈 粵電力A公告預計上半年凈利潤8億元95億元去年同期虧損1372億元同比扭虧 -

潼關黃金(00340.HK)擬3.39億港元收購宏勇投資100%股份 格隆匯7月7日丨潼關黃金(00340 HK)公告,于2023年7月7日,公司(作為買

潼關黃金(00340.HK)擬3.39億港元收購宏勇投資100%股份 格隆匯7月7日丨潼關黃金(00340 HK)公告,于2023年7月7日,公司(作為買 -

小摩:轉型和AI利好被負面因素抵消 首予IBM(IBM.US)“中性”評級 摩根大通分析師BrianEssex發表研報,首次覆蓋IBM(IBM US),給予“中性

小摩:轉型和AI利好被負面因素抵消 首予IBM(IBM.US)“中性”評級 摩根大通分析師BrianEssex發表研報,首次覆蓋IBM(IBM US),給予“中性 -

Wolfe下修派拉蒙環球(PARA.US)業績預期 降評級至“跑輸大盤” WolfeResearch將派拉蒙環球(PARA US)的評級從“與同行評級”下調為“跑

Wolfe下修派拉蒙環球(PARA.US)業績預期 降評級至“跑輸大盤” WolfeResearch將派拉蒙環球(PARA US)的評級從“與同行評級”下調為“跑 -

順豐控股最新公告:4月速運物流業務營業收入146.46億元 同比增長27.29% 順豐控股公告,4月速運物流業務營業收入146 46億元,同比增長27 29%;

順豐控股最新公告:4月速運物流業務營業收入146.46億元 同比增長27.29% 順豐控股公告,4月速運物流業務營業收入146 46億元,同比增長27 29%; -

青島銀行(03866.HK):提名陳霜及杜寧為董事候選人 格隆匯7月7日丨青島銀行(002948)(03866 HK)公布,董事會于2023年7月7日

青島銀行(03866.HK):提名陳霜及杜寧為董事候選人 格隆匯7月7日丨青島銀行(002948)(03866 HK)公布,董事會于2023年7月7日 -

深圳大動作!24條舉措 劍指… 作為全國外貿重鎮,深圳在促進外貿穩定健康發展上再加碼!日前,中國人

深圳大動作!24條舉措 劍指… 作為全國外貿重鎮,深圳在促進外貿穩定健康發展上再加碼!日前,中國人 -

我國人工智能蓬勃發展 核心產業規模達5000億元 7月6日,2023世界人工智能大會在上海世博中心拉開帷幕。圖為參觀者在達

我國人工智能蓬勃發展 核心產業規模達5000億元 7月6日,2023世界人工智能大會在上海世博中心拉開帷幕。圖為參觀者在達 -

李玟媽媽首度發聲,公開吐槽外國女婿缺點,李玟曾為老公整晚痛哭 閱讀此文前,誠邀您點擊一下“關注”,方便您隨時查閱一系列優質文章,

李玟媽媽首度發聲,公開吐槽外國女婿缺點,李玟曾為老公整晚痛哭 閱讀此文前,誠邀您點擊一下“關注”,方便您隨時查閱一系列優質文章, -

中國銀河(06881)因可轉債轉股2022年末期股息調整為每股0.22533元 智通財經APP訊,中國銀河(601881)(06881)公布,由于公司于2022年3月24

中國銀河(06881)因可轉債轉股2022年末期股息調整為每股0.22533元 智通財經APP訊,中國銀河(601881)(06881)公布,由于公司于2022年3月24 -

正業科技(300410.SZ)選舉余笑兵為董事長 智通財經APP訊,正業科技(300410)(300410 SZ)公告,公司董事會同意選舉

正業科技(300410.SZ)選舉余笑兵為董事長 智通財經APP訊,正業科技(300410)(300410 SZ)公告,公司董事會同意選舉 -

紫金礦業(02899.HK)預計上半年凈利約102億元 同比下降19.2% 格隆匯7月7日丨紫金礦業(02899 HK)公告,公司預計2023年半年度實現歸屬

紫金礦業(02899.HK)預計上半年凈利約102億元 同比下降19.2% 格隆匯7月7日丨紫金礦業(02899 HK)公告,公司預計2023年半年度實現歸屬 -

中航光電(002179.SZ):擬投資27.2億元在洛陽購置土地建高端互連科技產業社區項目 格隆匯7月7日丨中航光電(002179)(002179 SZ)公布,2023年7月7日,公司

中航光電(002179.SZ):擬投資27.2億元在洛陽購置土地建高端互連科技產業社區項目 格隆匯7月7日丨中航光電(002179)(002179 SZ)公布,2023年7月7日,公司 -

建發國際集團(01908.HK)根據以股代息計劃發行1.08億股 格隆匯7月7日丨建發國際集團(01908 HK)公布,根據公司以股代息計劃而于

建發國際集團(01908.HK)根據以股代息計劃發行1.08億股 格隆匯7月7日丨建發國際集團(01908 HK)公布,根據公司以股代息計劃而于

熱門資訊

-

源自福特超級平臺,江鈴福特新款輕客來襲 說起輕客,大家的第一印象總是全順...

源自福特超級平臺,江鈴福特新款輕客來襲 說起輕客,大家的第一印象總是全順... -

多彩新媒協同多省IPTV加速布局大屏生態圈,“看中國”深度挖掘 智能大屏價值 6月16日,在北京論道暨第25屆中國...

多彩新媒協同多省IPTV加速布局大屏生態圈,“看中國”深度挖掘 智能大屏價值 6月16日,在北京論道暨第25屆中國... -

出擊!招行信用卡協助警方重拳打擊金融“黑灰產”! 在上海浦東新區某大廈內,掛著“法...

出擊!招行信用卡協助警方重拳打擊金融“黑灰產”! 在上海浦東新區某大廈內,掛著“法... -

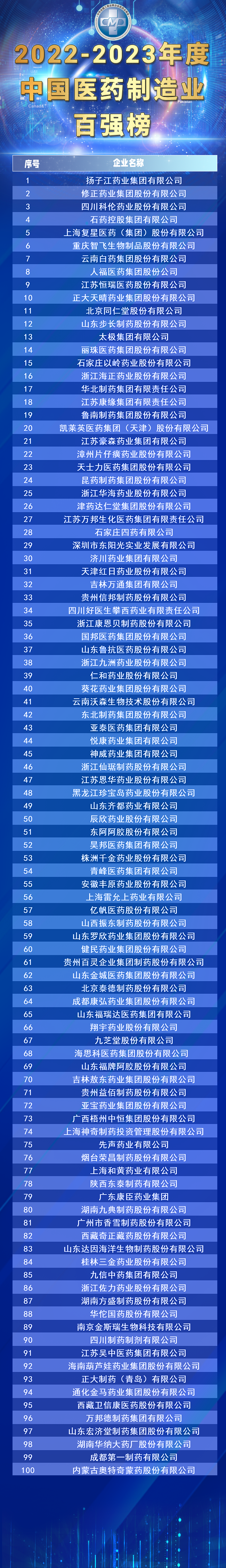

“2022-2023年度中國醫藥制造業百強”出爐,揚子江藥業集團榮登榜首 7月4日,由全國工商聯醫藥業商會、...

“2022-2023年度中國醫藥制造業百強”出爐,揚子江藥業集團榮登榜首 7月4日,由全國工商聯醫藥業商會、...

文章排行

圖片新聞

-

國慶假期懷柔北部山區的紅葉進入最佳觀賞期 吸引游客前來賞秋景 國慶假期,懷柔北部山區的紅葉進入...

國慶假期懷柔北部山區的紅葉進入最佳觀賞期 吸引游客前來賞秋景 國慶假期,懷柔北部山區的紅葉進入... -

重磅!四川省科創貸款較年初新增620.35億元 同比增長21.22% 記者日前從中國人民銀行成都分行獲...

重磅!四川省科創貸款較年初新增620.35億元 同比增長21.22% 記者日前從中國人民銀行成都分行獲... -

252項“全程網辦”!川渝兩地企業登記檔案實現跨區域互查 8月30日,記者從省大數據中心獲悉...

252項“全程網辦”!川渝兩地企業登記檔案實現跨區域互查 8月30日,記者從省大數據中心獲悉... -

2022年中國國際服務貿易交易會在京舉辦 四川參展企業數量創新高 8月31日至9月5日,主題為服務合作...

2022年中國國際服務貿易交易會在京舉辦 四川參展企業數量創新高 8月31日至9月5日,主題為服務合作...