【環球聚看點】“紫東太初”全模態大模型發布 AI聽《月光曲》就能聊貝多芬

(資料圖片)

(資料圖片)

湖北日報訊(記者張真真、通訊員詹欣芮)透過《月光曲》就可以暢談貝多芬的故事,在三維場景里實現精準定位,通過圖像與聲音結合完成場景分析……6月16日,在人工智能框架生態峰會2023上,中國科學院自動化研究所聯合武漢人工智能研究院正式發布“紫東太初”全模態大模型,種種新奇表現贏得現場觀眾熱烈反響。

“紫東太初”全模態大模型,是在千億參數多模態大模型“紫東太初”1.0基礎上升級打造的2.0版本。

2021年9月,中國科學院自動化研究所成功打造了“紫東太初”1.0多模態大模型,貫通語音、圖像、文字等信息。比如,AI(人工智能)在學習時,“看到”貓的圖像或者聽到貓的叫聲,就能準確識別出是貓。

除“圖-音-文”外,“紫東太初”2.0加入了視頻、傳感信號、3D點云等更多模態,完成了音樂、圖片和視頻等數據之間的跨模態對齊,能夠處理音樂視頻分析、三維導航等多模態關聯應用需求,并可實現音樂、視頻等多模態內容理解和生成。

中國科學院自動化研究所相關負責人表示,從1.0到2.0,“紫東太初”大模型打通了感知、認知乃至決策的交互屏障,使人工智能進一步感知世界、認知世界,從而延伸出更加強大的通用能力。

“紫東太初”2.0以自動化所自研算法為核心,以國產化基礎軟硬件平臺昇騰AI為基礎,依托武漢人工智能計算中心算力支持,著力打造全棧國產化通用人工智能底座,協同構建我國通用人工智能自主可控發展生態。

目前,“紫東太初”大模型已展現出廣闊的產業應用前景,在神經外科手術導航、短視頻內容審核、法律咨詢、醫療多模態鑒別診斷、交通違規圖像研讀等領域開始了一系列引領性、示范性應用。

在醫療場景,“紫東太初”大模型部署于神經外科機器人,可實現在術中實時融合視覺、觸覺等多模態信息,協助醫生對手術場景進行實時推理判斷,并嘗試在人類罕見病診療這個挑戰性醫學領域有所突破。

關鍵詞:

-

2023年愛心售報|小報童帶病堅持來賣報 孩子成長迅速讓家長很欣慰 揚子晚報7月7日訊(記者季宇軒實習生王元釗)7月6日是2023年揚子晚報暑

2023年愛心售報|小報童帶病堅持來賣報 孩子成長迅速讓家長很欣慰 揚子晚報7月7日訊(記者季宇軒實習生王元釗)7月6日是2023年揚子晚報暑 -

我國人工智能蓬勃發展 核心產業規模達5000億元 7月6日,2023世界人工智能大會在上海世博中心拉開帷幕。圖為參觀者在達

我國人工智能蓬勃發展 核心產業規模達5000億元 7月6日,2023世界人工智能大會在上海世博中心拉開帷幕。圖為參觀者在達 -

應對強降雨 嶗山巴士突擊隊24小時備戰 近日,島城迎來強降雨天氣。為保證所屬公交線路安全運行,青島城運控股

應對強降雨 嶗山巴士突擊隊24小時備戰 近日,島城迎來強降雨天氣。為保證所屬公交線路安全運行,青島城運控股 -

齊車公司為新西蘭“量身定制”鐵路貨車 中新網齊齊哈爾7月7日電 (劉廷祿)7月7日,由中車齊車集團齊車公司

齊車公司為新西蘭“量身定制”鐵路貨車 中新網齊齊哈爾7月7日電 (劉廷祿)7月7日,由中車齊車集團齊車公司 -

什么是edn EDN是一種數據交換標準格式(ESDF),它是一種在電子設計領域中廣泛使

什么是edn EDN是一種數據交換標準格式(ESDF),它是一種在電子設計領域中廣泛使 -

教育部部署做好2023年中小學暑期安全工作 暑假即將來臨,為使廣大中小學生度過一個平安快樂的假期,日前,教育部

教育部部署做好2023年中小學暑期安全工作 暑假即將來臨,為使廣大中小學生度過一個平安快樂的假期,日前,教育部

-

云南建投混凝土(01847)附屬高分子公司訂立保理協議 智通財經APP訊,云南建投混凝土(01847)發布公告,于2023年7月7日,該公

云南建投混凝土(01847)附屬高分子公司訂立保理協議 智通財經APP訊,云南建投混凝土(01847)發布公告,于2023年7月7日,該公 -

明源云(00909.HK)委任梁瑞冰為聯席公司秘書 格隆匯7月7日丨明源云(00909 HK)宣布,司徒嘉怡因其他工作安排,已提呈

明源云(00909.HK)委任梁瑞冰為聯席公司秘書 格隆匯7月7日丨明源云(00909 HK)宣布,司徒嘉怡因其他工作安排,已提呈 -

彩客新能源(01986)4月21日斥資8.58萬港元回購6.2萬股 智通財經APP訊,彩客新能源(01986)發布公告,于2023年4月21日,該公司

彩客新能源(01986)4月21日斥資8.58萬港元回購6.2萬股 智通財經APP訊,彩客新能源(01986)發布公告,于2023年4月21日,該公司 -

富祥藥業:7月6日接受機構調研,包括知名機構盤京投資的多家機構參與 2023年7月7日富祥藥業(300497)發布公告稱公司于2023年7月6日接受機構

富祥藥業:7月6日接受機構調研,包括知名機構盤京投資的多家機構參與 2023年7月7日富祥藥業(300497)發布公告稱公司于2023年7月6日接受機構 -

廣東宏大:預計2023年1-6月盈利,凈利潤同比增20%至30% 廣東宏大發布業績預告,預計2023年1-6月歸屬凈利潤盈利3 02億元至3 27

廣東宏大:預計2023年1-6月盈利,凈利潤同比增20%至30% 廣東宏大發布業績預告,預計2023年1-6月歸屬凈利潤盈利3 02億元至3 27 -

馮奎章_馮奎 1、馮奎賣妻是明朝末年的故事。2、《馮奎賣妻》保定府有一對夫妻叫馮奎

馮奎章_馮奎 1、馮奎賣妻是明朝末年的故事。2、《馮奎賣妻》保定府有一對夫妻叫馮奎 -

注意!家里這些物品也要“防暑降溫” 入夏以來,多輪高溫天氣來襲用電需求量較常年同期偏高面對“烤”驗日常

注意!家里這些物品也要“防暑降溫” 入夏以來,多輪高溫天氣來襲用電需求量較常年同期偏高面對“烤”驗日常 -

2023年愛心售報|小報童帶病堅持來賣報 孩子成長迅速讓家長很欣慰 揚子晚報7月7日訊(記者季宇軒實習生王元釗)7月6日是2023年揚子晚報暑

2023年愛心售報|小報童帶病堅持來賣報 孩子成長迅速讓家長很欣慰 揚子晚報7月7日訊(記者季宇軒實習生王元釗)7月6日是2023年揚子晚報暑 -

粵電力A最新公告:預計上半年凈利潤8億元-9.5億元 同比扭虧為盈 粵電力A公告預計上半年凈利潤8億元95億元去年同期虧損1372億元同比扭虧

粵電力A最新公告:預計上半年凈利潤8億元-9.5億元 同比扭虧為盈 粵電力A公告預計上半年凈利潤8億元95億元去年同期虧損1372億元同比扭虧 -

潼關黃金(00340.HK)擬3.39億港元收購宏勇投資100%股份 格隆匯7月7日丨潼關黃金(00340 HK)公告,于2023年7月7日,公司(作為買

潼關黃金(00340.HK)擬3.39億港元收購宏勇投資100%股份 格隆匯7月7日丨潼關黃金(00340 HK)公告,于2023年7月7日,公司(作為買 -

小摩:轉型和AI利好被負面因素抵消 首予IBM(IBM.US)“中性”評級 摩根大通分析師BrianEssex發表研報,首次覆蓋IBM(IBM US),給予“中性

小摩:轉型和AI利好被負面因素抵消 首予IBM(IBM.US)“中性”評級 摩根大通分析師BrianEssex發表研報,首次覆蓋IBM(IBM US),給予“中性 -

Wolfe下修派拉蒙環球(PARA.US)業績預期 降評級至“跑輸大盤” WolfeResearch將派拉蒙環球(PARA US)的評級從“與同行評級”下調為“跑

Wolfe下修派拉蒙環球(PARA.US)業績預期 降評級至“跑輸大盤” WolfeResearch將派拉蒙環球(PARA US)的評級從“與同行評級”下調為“跑 -

順豐控股最新公告:4月速運物流業務營業收入146.46億元 同比增長27.29% 順豐控股公告,4月速運物流業務營業收入146 46億元,同比增長27 29%;

順豐控股最新公告:4月速運物流業務營業收入146.46億元 同比增長27.29% 順豐控股公告,4月速運物流業務營業收入146 46億元,同比增長27 29%; -

青島銀行(03866.HK):提名陳霜及杜寧為董事候選人 格隆匯7月7日丨青島銀行(002948)(03866 HK)公布,董事會于2023年7月7日

青島銀行(03866.HK):提名陳霜及杜寧為董事候選人 格隆匯7月7日丨青島銀行(002948)(03866 HK)公布,董事會于2023年7月7日 -

深圳大動作!24條舉措 劍指… 作為全國外貿重鎮,深圳在促進外貿穩定健康發展上再加碼!日前,中國人

深圳大動作!24條舉措 劍指… 作為全國外貿重鎮,深圳在促進外貿穩定健康發展上再加碼!日前,中國人 -

我國人工智能蓬勃發展 核心產業規模達5000億元 7月6日,2023世界人工智能大會在上海世博中心拉開帷幕。圖為參觀者在達

我國人工智能蓬勃發展 核心產業規模達5000億元 7月6日,2023世界人工智能大會在上海世博中心拉開帷幕。圖為參觀者在達 -

李玟媽媽首度發聲,公開吐槽外國女婿缺點,李玟曾為老公整晚痛哭 閱讀此文前,誠邀您點擊一下“關注”,方便您隨時查閱一系列優質文章,

李玟媽媽首度發聲,公開吐槽外國女婿缺點,李玟曾為老公整晚痛哭 閱讀此文前,誠邀您點擊一下“關注”,方便您隨時查閱一系列優質文章, -

中國銀河(06881)因可轉債轉股2022年末期股息調整為每股0.22533元 智通財經APP訊,中國銀河(601881)(06881)公布,由于公司于2022年3月24

中國銀河(06881)因可轉債轉股2022年末期股息調整為每股0.22533元 智通財經APP訊,中國銀河(601881)(06881)公布,由于公司于2022年3月24 -

正業科技(300410.SZ)選舉余笑兵為董事長 智通財經APP訊,正業科技(300410)(300410 SZ)公告,公司董事會同意選舉

正業科技(300410.SZ)選舉余笑兵為董事長 智通財經APP訊,正業科技(300410)(300410 SZ)公告,公司董事會同意選舉 -

紫金礦業(02899.HK)預計上半年凈利約102億元 同比下降19.2% 格隆匯7月7日丨紫金礦業(02899 HK)公告,公司預計2023年半年度實現歸屬

紫金礦業(02899.HK)預計上半年凈利約102億元 同比下降19.2% 格隆匯7月7日丨紫金礦業(02899 HK)公告,公司預計2023年半年度實現歸屬 -

中航光電(002179.SZ):擬投資27.2億元在洛陽購置土地建高端互連科技產業社區項目 格隆匯7月7日丨中航光電(002179)(002179 SZ)公布,2023年7月7日,公司

中航光電(002179.SZ):擬投資27.2億元在洛陽購置土地建高端互連科技產業社區項目 格隆匯7月7日丨中航光電(002179)(002179 SZ)公布,2023年7月7日,公司 -

建發國際集團(01908.HK)根據以股代息計劃發行1.08億股 格隆匯7月7日丨建發國際集團(01908 HK)公布,根據公司以股代息計劃而于

建發國際集團(01908.HK)根據以股代息計劃發行1.08億股 格隆匯7月7日丨建發國際集團(01908 HK)公布,根據公司以股代息計劃而于 -

“推特殺手”一天拿下3000萬用戶!馬斯克或怒告扎克伯格 中新網7月7日電日前,Meta首席執行官扎克伯格收到了一封“警告信”——

“推特殺手”一天拿下3000萬用戶!馬斯克或怒告扎克伯格 中新網7月7日電日前,Meta首席執行官扎克伯格收到了一封“警告信”—— -

應對強降雨 嶗山巴士突擊隊24小時備戰 近日,島城迎來強降雨天氣。為保證所屬公交線路安全運行,青島城運控股

應對強降雨 嶗山巴士突擊隊24小時備戰 近日,島城迎來強降雨天氣。為保證所屬公交線路安全運行,青島城運控股 -

海口迎來暑期學車潮 這樣做可以避免學車“坑” 原標題:海口迎來暑期學車潮這樣做可以避免學車“坑”新海南客戶端、南

海口迎來暑期學車潮 這樣做可以避免學車“坑” 原標題:海口迎來暑期學車潮這樣做可以避免學車“坑”新海南客戶端、南 -

高端降價,中低端發力!AMD新品還能觸底反彈嗎? 2022年9月15日,是一個所有電腦DIY玩家都會銘記的日子。ETH順利合并,

高端降價,中低端發力!AMD新品還能觸底反彈嗎? 2022年9月15日,是一個所有電腦DIY玩家都會銘記的日子。ETH順利合并, -

齊車公司為新西蘭“量身定制”鐵路貨車 中新網齊齊哈爾7月7日電 (劉廷祿)7月7日,由中車齊車集團齊車公司

齊車公司為新西蘭“量身定制”鐵路貨車 中新網齊齊哈爾7月7日電 (劉廷祿)7月7日,由中車齊車集團齊車公司 -

廣匯物流最新公告:擬定增募資不超過18億元 控股股東參與認購 廣匯物流公告,擬定增募資不超過18億元,用于寧東煤炭儲運基地項目(含

廣匯物流最新公告:擬定增募資不超過18億元 控股股東參與認購 廣匯物流公告,擬定增募資不超過18億元,用于寧東煤炭儲運基地項目(含 -

利歐股份(002131.SZ):部分董事、高管擬合計減持不超616.7萬股 格隆匯7月7日丨利歐股份(002131)(002131 SZ)公布,公司于2023年7月7日

利歐股份(002131.SZ):部分董事、高管擬合計減持不超616.7萬股 格隆匯7月7日丨利歐股份(002131)(002131 SZ)公布,公司于2023年7月7日 -

湖北能源(000883.SZ):6月完成發電量36.14億千瓦時,同比增長12.83% 格隆匯7月7日丨湖北能源(000883)(000883 SZ)公布,2023年6月,公司完成

湖北能源(000883.SZ):6月完成發電量36.14億千瓦時,同比增長12.83% 格隆匯7月7日丨湖北能源(000883)(000883 SZ)公布,2023年6月,公司完成

熱門資訊

-

源自福特超級平臺,江鈴福特新款輕客來襲 說起輕客,大家的第一印象總是全順...

源自福特超級平臺,江鈴福特新款輕客來襲 說起輕客,大家的第一印象總是全順... -

多彩新媒協同多省IPTV加速布局大屏生態圈,“看中國”深度挖掘 智能大屏價值 6月16日,在北京論道暨第25屆中國...

多彩新媒協同多省IPTV加速布局大屏生態圈,“看中國”深度挖掘 智能大屏價值 6月16日,在北京論道暨第25屆中國... -

出擊!招行信用卡協助警方重拳打擊金融“黑灰產”! 在上海浦東新區某大廈內,掛著“法...

出擊!招行信用卡協助警方重拳打擊金融“黑灰產”! 在上海浦東新區某大廈內,掛著“法... -

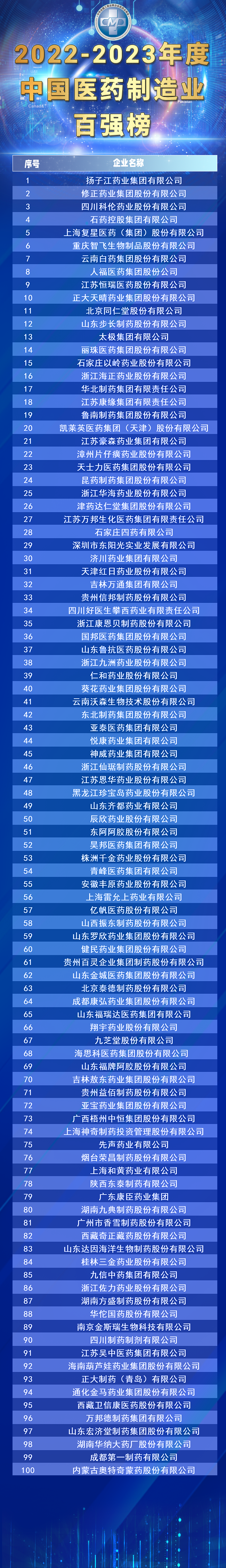

“2022-2023年度中國醫藥制造業百強”出爐,揚子江藥業集團榮登榜首 7月4日,由全國工商聯醫藥業商會、...

“2022-2023年度中國醫藥制造業百強”出爐,揚子江藥業集團榮登榜首 7月4日,由全國工商聯醫藥業商會、...

文章排行

圖片新聞

-

國慶假期懷柔北部山區的紅葉進入最佳觀賞期 吸引游客前來賞秋景 國慶假期,懷柔北部山區的紅葉進入...

國慶假期懷柔北部山區的紅葉進入最佳觀賞期 吸引游客前來賞秋景 國慶假期,懷柔北部山區的紅葉進入... -

重磅!四川省科創貸款較年初新增620.35億元 同比增長21.22% 記者日前從中國人民銀行成都分行獲...

重磅!四川省科創貸款較年初新增620.35億元 同比增長21.22% 記者日前從中國人民銀行成都分行獲... -

252項“全程網辦”!川渝兩地企業登記檔案實現跨區域互查 8月30日,記者從省大數據中心獲悉...

252項“全程網辦”!川渝兩地企業登記檔案實現跨區域互查 8月30日,記者從省大數據中心獲悉... -

2022年中國國際服務貿易交易會在京舉辦 四川參展企業數量創新高 8月31日至9月5日,主題為服務合作...

2022年中國國際服務貿易交易會在京舉辦 四川參展企業數量創新高 8月31日至9月5日,主題為服務合作...